git 项目大瘦身

This commit is contained in:

commit

81abcb3f3a

|

|

@ -0,0 +1,107 @@

|

|||

# Byte-compiled / optimized / DLL files

|

||||

__pycache__/

|

||||

*.py[cod]

|

||||

*$py.class

|

||||

.vscode

|

||||

|

||||

# C extensions

|

||||

*.so

|

||||

|

||||

# Distribution / packaging

|

||||

.Python

|

||||

build/

|

||||

develop-eggs/

|

||||

dist/

|

||||

downloads/

|

||||

eggs/

|

||||

.eggs/

|

||||

lib/

|

||||

lib64/

|

||||

parts/

|

||||

sdist/

|

||||

var/

|

||||

wheels/

|

||||

*.egg-info/

|

||||

.installed.cfg

|

||||

*.egg

|

||||

MANIFEST

|

||||

|

||||

# PyInstaller

|

||||

# Usually these files are written by a python script from a template

|

||||

# before PyInstaller builds the exe, so as to inject date/other infos into it.

|

||||

*.manifest

|

||||

*.spec

|

||||

|

||||

# Installer logs

|

||||

pip-log.txt

|

||||

pip-delete-this-directory.txt

|

||||

|

||||

# Unit test / coverage reports

|

||||

htmlcov/

|

||||

.tox/

|

||||

.coverage

|

||||

.coverage.*

|

||||

.cache

|

||||

nosetests.xml

|

||||

coverage.xml

|

||||

*.cover

|

||||

.hypothesis/

|

||||

.pytest_cache/

|

||||

|

||||

# Translations

|

||||

*.mo

|

||||

*.pot

|

||||

|

||||

# Django stuff:

|

||||

*.log

|

||||

local_settings.py

|

||||

db.sqlite3

|

||||

|

||||

# Flask stuff:

|

||||

instance/

|

||||

.webassets-cache

|

||||

|

||||

# Scrapy stuff:

|

||||

.scrapy

|

||||

|

||||

# Sphinx documentation

|

||||

_book/

|

||||

docs/_build/

|

||||

|

||||

# PyBuilder

|

||||

target/

|

||||

|

||||

# Jupyter Notebook

|

||||

.ipynb_checkpoints

|

||||

|

||||

# pyenv

|

||||

.python-version

|

||||

|

||||

# celery beat schedule file

|

||||

celerybeat-schedule

|

||||

|

||||

# SageMath parsed files

|

||||

*.sage.py

|

||||

|

||||

# Environments

|

||||

.env

|

||||

.venv

|

||||

env/

|

||||

venv/

|

||||

ENV/

|

||||

env.bak/

|

||||

venv.bak/

|

||||

|

||||

# Spyder project settings

|

||||

.spyderproject

|

||||

.spyproject

|

||||

|

||||

# Rope project settings

|

||||

.ropeproject

|

||||

|

||||

# mkdocs documentation

|

||||

/site

|

||||

|

||||

# mypy

|

||||

.mypy_cache/

|

||||

node_modules

|

||||

|

|

@ -0,0 +1,674 @@

|

|||

GNU GENERAL PUBLIC LICENSE

|

||||

Version 3, 29 June 2007

|

||||

|

||||

Copyright (C) 2007 Free Software Foundation, Inc. <http://fsf.org/>

|

||||

Everyone is permitted to copy and distribute verbatim copies

|

||||

of this license document, but changing it is not allowed.

|

||||

|

||||

Preamble

|

||||

|

||||

The GNU General Public License is a free, copyleft license for

|

||||

software and other kinds of works.

|

||||

|

||||

The licenses for most software and other practical works are designed

|

||||

to take away your freedom to share and change the works. By contrast,

|

||||

the GNU General Public License is intended to guarantee your freedom to

|

||||

share and change all versions of a program--to make sure it remains free

|

||||

software for all its users. We, the Free Software Foundation, use the

|

||||

GNU General Public License for most of our software; it applies also to

|

||||

any other work released this way by its authors. You can apply it to

|

||||

your programs, too.

|

||||

|

||||

When we speak of free software, we are referring to freedom, not

|

||||

price. Our General Public Licenses are designed to make sure that you

|

||||

have the freedom to distribute copies of free software (and charge for

|

||||

them if you wish), that you receive source code or can get it if you

|

||||

want it, that you can change the software or use pieces of it in new

|

||||

free programs, and that you know you can do these things.

|

||||

|

||||

To protect your rights, we need to prevent others from denying you

|

||||

these rights or asking you to surrender the rights. Therefore, you have

|

||||

certain responsibilities if you distribute copies of the software, or if

|

||||

you modify it: responsibilities to respect the freedom of others.

|

||||

|

||||

For example, if you distribute copies of such a program, whether

|

||||

gratis or for a fee, you must pass on to the recipients the same

|

||||

freedoms that you received. You must make sure that they, too, receive

|

||||

or can get the source code. And you must show them these terms so they

|

||||

know their rights.

|

||||

|

||||

Developers that use the GNU GPL protect your rights with two steps:

|

||||

(1) assert copyright on the software, and (2) offer you this License

|

||||

giving you legal permission to copy, distribute and/or modify it.

|

||||

|

||||

For the developers' and authors' protection, the GPL clearly explains

|

||||

that there is no warranty for this free software. For both users' and

|

||||

authors' sake, the GPL requires that modified versions be marked as

|

||||

changed, so that their problems will not be attributed erroneously to

|

||||

authors of previous versions.

|

||||

|

||||

Some devices are designed to deny users access to install or run

|

||||

modified versions of the software inside them, although the manufacturer

|

||||

can do so. This is fundamentally incompatible with the aim of

|

||||

protecting users' freedom to change the software. The systematic

|

||||

pattern of such abuse occurs in the area of products for individuals to

|

||||

use, which is precisely where it is most unacceptable. Therefore, we

|

||||

have designed this version of the GPL to prohibit the practice for those

|

||||

products. If such problems arise substantially in other domains, we

|

||||

stand ready to extend this provision to those domains in future versions

|

||||

of the GPL, as needed to protect the freedom of users.

|

||||

|

||||

Finally, every program is threatened constantly by software patents.

|

||||

States should not allow patents to restrict development and use of

|

||||

software on general-purpose computers, but in those that do, we wish to

|

||||

avoid the special danger that patents applied to a free program could

|

||||

make it effectively proprietary. To prevent this, the GPL assures that

|

||||

patents cannot be used to render the program non-free.

|

||||

|

||||

The precise terms and conditions for copying, distribution and

|

||||

modification follow.

|

||||

|

||||

TERMS AND CONDITIONS

|

||||

|

||||

0. Definitions.

|

||||

|

||||

"This License" refers to version 3 of the GNU General Public License.

|

||||

|

||||

"Copyright" also means copyright-like laws that apply to other kinds of

|

||||

works, such as semiconductor masks.

|

||||

|

||||

"The Program" refers to any copyrightable work licensed under this

|

||||

License. Each licensee is addressed as "you". "Licensees" and

|

||||

"recipients" may be individuals or organizations.

|

||||

|

||||

To "modify" a work means to copy from or adapt all or part of the work

|

||||

in a fashion requiring copyright permission, other than the making of an

|

||||

exact copy. The resulting work is called a "modified version" of the

|

||||

earlier work or a work "based on" the earlier work.

|

||||

|

||||

A "covered work" means either the unmodified Program or a work based

|

||||

on the Program.

|

||||

|

||||

To "propagate" a work means to do anything with it that, without

|

||||

permission, would make you directly or secondarily liable for

|

||||

infringement under applicable copyright law, except executing it on a

|

||||

computer or modifying a private copy. Propagation includes copying,

|

||||

distribution (with or without modification), making available to the

|

||||

public, and in some countries other activities as well.

|

||||

|

||||

To "convey" a work means any kind of propagation that enables other

|

||||

parties to make or receive copies. Mere interaction with a user through

|

||||

a computer network, with no transfer of a copy, is not conveying.

|

||||

|

||||

An interactive user interface displays "Appropriate Legal Notices"

|

||||

to the extent that it includes a convenient and prominently visible

|

||||

feature that (1) displays an appropriate copyright notice, and (2)

|

||||

tells the user that there is no warranty for the work (except to the

|

||||

extent that warranties are provided), that licensees may convey the

|

||||

work under this License, and how to view a copy of this License. If

|

||||

the interface presents a list of user commands or options, such as a

|

||||

menu, a prominent item in the list meets this criterion.

|

||||

|

||||

1. Source Code.

|

||||

|

||||

The "source code" for a work means the preferred form of the work

|

||||

for making modifications to it. "Object code" means any non-source

|

||||

form of a work.

|

||||

|

||||

A "Standard Interface" means an interface that either is an official

|

||||

standard defined by a recognized standards body, or, in the case of

|

||||

interfaces specified for a particular programming language, one that

|

||||

is widely used among developers working in that language.

|

||||

|

||||

The "System Libraries" of an executable work include anything, other

|

||||

than the work as a whole, that (a) is included in the normal form of

|

||||

packaging a Major Component, but which is not part of that Major

|

||||

Component, and (b) serves only to enable use of the work with that

|

||||

Major Component, or to implement a Standard Interface for which an

|

||||

implementation is available to the public in source code form. A

|

||||

"Major Component", in this context, means a major essential component

|

||||

(kernel, window system, and so on) of the specific operating system

|

||||

(if any) on which the executable work runs, or a compiler used to

|

||||

produce the work, or an object code interpreter used to run it.

|

||||

|

||||

The "Corresponding Source" for a work in object code form means all

|

||||

the source code needed to generate, install, and (for an executable

|

||||

work) run the object code and to modify the work, including scripts to

|

||||

control those activities. However, it does not include the work's

|

||||

System Libraries, or general-purpose tools or generally available free

|

||||

programs which are used unmodified in performing those activities but

|

||||

which are not part of the work. For example, Corresponding Source

|

||||

includes interface definition files associated with source files for

|

||||

the work, and the source code for shared libraries and dynamically

|

||||

linked subprograms that the work is specifically designed to require,

|

||||

such as by intimate data communication or control flow between those

|

||||

subprograms and other parts of the work.

|

||||

|

||||

The Corresponding Source need not include anything that users

|

||||

can regenerate automatically from other parts of the Corresponding

|

||||

Source.

|

||||

|

||||

The Corresponding Source for a work in source code form is that

|

||||

same work.

|

||||

|

||||

2. Basic Permissions.

|

||||

|

||||

All rights granted under this License are granted for the term of

|

||||

copyright on the Program, and are irrevocable provided the stated

|

||||

conditions are met. This License explicitly affirms your unlimited

|

||||

permission to run the unmodified Program. The output from running a

|

||||

covered work is covered by this License only if the output, given its

|

||||

content, constitutes a covered work. This License acknowledges your

|

||||

rights of fair use or other equivalent, as provided by copyright law.

|

||||

|

||||

You may make, run and propagate covered works that you do not

|

||||

convey, without conditions so long as your license otherwise remains

|

||||

in force. You may convey covered works to others for the sole purpose

|

||||

of having them make modifications exclusively for you, or provide you

|

||||

with facilities for running those works, provided that you comply with

|

||||

the terms of this License in conveying all material for which you do

|

||||

not control copyright. Those thus making or running the covered works

|

||||

for you must do so exclusively on your behalf, under your direction

|

||||

and control, on terms that prohibit them from making any copies of

|

||||

your copyrighted material outside their relationship with you.

|

||||

|

||||

Conveying under any other circumstances is permitted solely under

|

||||

the conditions stated below. Sublicensing is not allowed; section 10

|

||||

makes it unnecessary.

|

||||

|

||||

3. Protecting Users' Legal Rights From Anti-Circumvention Law.

|

||||

|

||||

No covered work shall be deemed part of an effective technological

|

||||

measure under any applicable law fulfilling obligations under article

|

||||

11 of the WIPO copyright treaty adopted on 20 December 1996, or

|

||||

similar laws prohibiting or restricting circumvention of such

|

||||

measures.

|

||||

|

||||

When you convey a covered work, you waive any legal power to forbid

|

||||

circumvention of technological measures to the extent such circumvention

|

||||

is effected by exercising rights under this License with respect to

|

||||

the covered work, and you disclaim any intention to limit operation or

|

||||

modification of the work as a means of enforcing, against the work's

|

||||

users, your or third parties' legal rights to forbid circumvention of

|

||||

technological measures.

|

||||

|

||||

4. Conveying Verbatim Copies.

|

||||

|

||||

You may convey verbatim copies of the Program's source code as you

|

||||

receive it, in any medium, provided that you conspicuously and

|

||||

appropriately publish on each copy an appropriate copyright notice;

|

||||

keep intact all notices stating that this License and any

|

||||

non-permissive terms added in accord with section 7 apply to the code;

|

||||

keep intact all notices of the absence of any warranty; and give all

|

||||

recipients a copy of this License along with the Program.

|

||||

|

||||

You may charge any price or no price for each copy that you convey,

|

||||

and you may offer support or warranty protection for a fee.

|

||||

|

||||

5. Conveying Modified Source Versions.

|

||||

|

||||

You may convey a work based on the Program, or the modifications to

|

||||

produce it from the Program, in the form of source code under the

|

||||

terms of section 4, provided that you also meet all of these conditions:

|

||||

|

||||

a) The work must carry prominent notices stating that you modified

|

||||

it, and giving a relevant date.

|

||||

|

||||

b) The work must carry prominent notices stating that it is

|

||||

released under this License and any conditions added under section

|

||||

7. This requirement modifies the requirement in section 4 to

|

||||

"keep intact all notices".

|

||||

|

||||

c) You must license the entire work, as a whole, under this

|

||||

License to anyone who comes into possession of a copy. This

|

||||

License will therefore apply, along with any applicable section 7

|

||||

additional terms, to the whole of the work, and all its parts,

|

||||

regardless of how they are packaged. This License gives no

|

||||

permission to license the work in any other way, but it does not

|

||||

invalidate such permission if you have separately received it.

|

||||

|

||||

d) If the work has interactive user interfaces, each must display

|

||||

Appropriate Legal Notices; however, if the Program has interactive

|

||||

interfaces that do not display Appropriate Legal Notices, your

|

||||

work need not make them do so.

|

||||

|

||||

A compilation of a covered work with other separate and independent

|

||||

works, which are not by their nature extensions of the covered work,

|

||||

and which are not combined with it such as to form a larger program,

|

||||

in or on a volume of a storage or distribution medium, is called an

|

||||

"aggregate" if the compilation and its resulting copyright are not

|

||||

used to limit the access or legal rights of the compilation's users

|

||||

beyond what the individual works permit. Inclusion of a covered work

|

||||

in an aggregate does not cause this License to apply to the other

|

||||

parts of the aggregate.

|

||||

|

||||

6. Conveying Non-Source Forms.

|

||||

|

||||

You may convey a covered work in object code form under the terms

|

||||

of sections 4 and 5, provided that you also convey the

|

||||

machine-readable Corresponding Source under the terms of this License,

|

||||

in one of these ways:

|

||||

|

||||

a) Convey the object code in, or embodied in, a physical product

|

||||

(including a physical distribution medium), accompanied by the

|

||||

Corresponding Source fixed on a durable physical medium

|

||||

customarily used for software interchange.

|

||||

|

||||

b) Convey the object code in, or embodied in, a physical product

|

||||

(including a physical distribution medium), accompanied by a

|

||||

written offer, valid for at least three years and valid for as

|

||||

long as you offer spare parts or customer support for that product

|

||||

model, to give anyone who possesses the object code either (1) a

|

||||

copy of the Corresponding Source for all the software in the

|

||||

product that is covered by this License, on a durable physical

|

||||

medium customarily used for software interchange, for a price no

|

||||

more than your reasonable cost of physically performing this

|

||||

conveying of source, or (2) access to copy the

|

||||

Corresponding Source from a network server at no charge.

|

||||

|

||||

c) Convey individual copies of the object code with a copy of the

|

||||

written offer to provide the Corresponding Source. This

|

||||

alternative is allowed only occasionally and noncommercially, and

|

||||

only if you received the object code with such an offer, in accord

|

||||

with subsection 6b.

|

||||

|

||||

d) Convey the object code by offering access from a designated

|

||||

place (gratis or for a charge), and offer equivalent access to the

|

||||

Corresponding Source in the same way through the same place at no

|

||||

further charge. You need not require recipients to copy the

|

||||

Corresponding Source along with the object code. If the place to

|

||||

copy the object code is a network server, the Corresponding Source

|

||||

may be on a different server (operated by you or a third party)

|

||||

that supports equivalent copying facilities, provided you maintain

|

||||

clear directions next to the object code saying where to find the

|

||||

Corresponding Source. Regardless of what server hosts the

|

||||

Corresponding Source, you remain obligated to ensure that it is

|

||||

available for as long as needed to satisfy these requirements.

|

||||

|

||||

e) Convey the object code using peer-to-peer transmission, provided

|

||||

you inform other peers where the object code and Corresponding

|

||||

Source of the work are being offered to the general public at no

|

||||

charge under subsection 6d.

|

||||

|

||||

A separable portion of the object code, whose source code is excluded

|

||||

from the Corresponding Source as a System Library, need not be

|

||||

included in conveying the object code work.

|

||||

|

||||

A "User Product" is either (1) a "consumer product", which means any

|

||||

tangible personal property which is normally used for personal, family,

|

||||

or household purposes, or (2) anything designed or sold for incorporation

|

||||

into a dwelling. In determining whether a product is a consumer product,

|

||||

doubtful cases shall be resolved in favor of coverage. For a particular

|

||||

product received by a particular user, "normally used" refers to a

|

||||

typical or common use of that class of product, regardless of the status

|

||||

of the particular user or of the way in which the particular user

|

||||

actually uses, or expects or is expected to use, the product. A product

|

||||

is a consumer product regardless of whether the product has substantial

|

||||

commercial, industrial or non-consumer uses, unless such uses represent

|

||||

the only significant mode of use of the product.

|

||||

|

||||

"Installation Information" for a User Product means any methods,

|

||||

procedures, authorization keys, or other information required to install

|

||||

and execute modified versions of a covered work in that User Product from

|

||||

a modified version of its Corresponding Source. The information must

|

||||

suffice to ensure that the continued functioning of the modified object

|

||||

code is in no case prevented or interfered with solely because

|

||||

modification has been made.

|

||||

|

||||

If you convey an object code work under this section in, or with, or

|

||||

specifically for use in, a User Product, and the conveying occurs as

|

||||

part of a transaction in which the right of possession and use of the

|

||||

User Product is transferred to the recipient in perpetuity or for a

|

||||

fixed term (regardless of how the transaction is characterized), the

|

||||

Corresponding Source conveyed under this section must be accompanied

|

||||

by the Installation Information. But this requirement does not apply

|

||||

if neither you nor any third party retains the ability to install

|

||||

modified object code on the User Product (for example, the work has

|

||||

been installed in ROM).

|

||||

|

||||

The requirement to provide Installation Information does not include a

|

||||

requirement to continue to provide support service, warranty, or updates

|

||||

for a work that has been modified or installed by the recipient, or for

|

||||

the User Product in which it has been modified or installed. Access to a

|

||||

network may be denied when the modification itself materially and

|

||||

adversely affects the operation of the network or violates the rules and

|

||||

protocols for communication across the network.

|

||||

|

||||

Corresponding Source conveyed, and Installation Information provided,

|

||||

in accord with this section must be in a format that is publicly

|

||||

documented (and with an implementation available to the public in

|

||||

source code form), and must require no special password or key for

|

||||

unpacking, reading or copying.

|

||||

|

||||

7. Additional Terms.

|

||||

|

||||

"Additional permissions" are terms that supplement the terms of this

|

||||

License by making exceptions from one or more of its conditions.

|

||||

Additional permissions that are applicable to the entire Program shall

|

||||

be treated as though they were included in this License, to the extent

|

||||

that they are valid under applicable law. If additional permissions

|

||||

apply only to part of the Program, that part may be used separately

|

||||

under those permissions, but the entire Program remains governed by

|

||||

this License without regard to the additional permissions.

|

||||

|

||||

When you convey a copy of a covered work, you may at your option

|

||||

remove any additional permissions from that copy, or from any part of

|

||||

it. (Additional permissions may be written to require their own

|

||||

removal in certain cases when you modify the work.) You may place

|

||||

additional permissions on material, added by you to a covered work,

|

||||

for which you have or can give appropriate copyright permission.

|

||||

|

||||

Notwithstanding any other provision of this License, for material you

|

||||

add to a covered work, you may (if authorized by the copyright holders of

|

||||

that material) supplement the terms of this License with terms:

|

||||

|

||||

a) Disclaiming warranty or limiting liability differently from the

|

||||

terms of sections 15 and 16 of this License; or

|

||||

|

||||

b) Requiring preservation of specified reasonable legal notices or

|

||||

author attributions in that material or in the Appropriate Legal

|

||||

Notices displayed by works containing it; or

|

||||

|

||||

c) Prohibiting misrepresentation of the origin of that material, or

|

||||

requiring that modified versions of such material be marked in

|

||||

reasonable ways as different from the original version; or

|

||||

|

||||

d) Limiting the use for publicity purposes of names of licensors or

|

||||

authors of the material; or

|

||||

|

||||

e) Declining to grant rights under trademark law for use of some

|

||||

trade names, trademarks, or service marks; or

|

||||

|

||||

f) Requiring indemnification of licensors and authors of that

|

||||

material by anyone who conveys the material (or modified versions of

|

||||

it) with contractual assumptions of liability to the recipient, for

|

||||

any liability that these contractual assumptions directly impose on

|

||||

those licensors and authors.

|

||||

|

||||

All other non-permissive additional terms are considered "further

|

||||

restrictions" within the meaning of section 10. If the Program as you

|

||||

received it, or any part of it, contains a notice stating that it is

|

||||

governed by this License along with a term that is a further

|

||||

restriction, you may remove that term. If a license document contains

|

||||

a further restriction but permits relicensing or conveying under this

|

||||

License, you may add to a covered work material governed by the terms

|

||||

of that license document, provided that the further restriction does

|

||||

not survive such relicensing or conveying.

|

||||

|

||||

If you add terms to a covered work in accord with this section, you

|

||||

must place, in the relevant source files, a statement of the

|

||||

additional terms that apply to those files, or a notice indicating

|

||||

where to find the applicable terms.

|

||||

|

||||

Additional terms, permissive or non-permissive, may be stated in the

|

||||

form of a separately written license, or stated as exceptions;

|

||||

the above requirements apply either way.

|

||||

|

||||

8. Termination.

|

||||

|

||||

You may not propagate or modify a covered work except as expressly

|

||||

provided under this License. Any attempt otherwise to propagate or

|

||||

modify it is void, and will automatically terminate your rights under

|

||||

this License (including any patent licenses granted under the third

|

||||

paragraph of section 11).

|

||||

|

||||

However, if you cease all violation of this License, then your

|

||||

license from a particular copyright holder is reinstated (a)

|

||||

provisionally, unless and until the copyright holder explicitly and

|

||||

finally terminates your license, and (b) permanently, if the copyright

|

||||

holder fails to notify you of the violation by some reasonable means

|

||||

prior to 60 days after the cessation.

|

||||

|

||||

Moreover, your license from a particular copyright holder is

|

||||

reinstated permanently if the copyright holder notifies you of the

|

||||

violation by some reasonable means, this is the first time you have

|

||||

received notice of violation of this License (for any work) from that

|

||||

copyright holder, and you cure the violation prior to 30 days after

|

||||

your receipt of the notice.

|

||||

|

||||

Termination of your rights under this section does not terminate the

|

||||

licenses of parties who have received copies or rights from you under

|

||||

this License. If your rights have been terminated and not permanently

|

||||

reinstated, you do not qualify to receive new licenses for the same

|

||||

material under section 10.

|

||||

|

||||

9. Acceptance Not Required for Having Copies.

|

||||

|

||||

You are not required to accept this License in order to receive or

|

||||

run a copy of the Program. Ancillary propagation of a covered work

|

||||

occurring solely as a consequence of using peer-to-peer transmission

|

||||

to receive a copy likewise does not require acceptance. However,

|

||||

nothing other than this License grants you permission to propagate or

|

||||

modify any covered work. These actions infringe copyright if you do

|

||||

not accept this License. Therefore, by modifying or propagating a

|

||||

covered work, you indicate your acceptance of this License to do so.

|

||||

|

||||

10. Automatic Licensing of Downstream Recipients.

|

||||

|

||||

Each time you convey a covered work, the recipient automatically

|

||||

receives a license from the original licensors, to run, modify and

|

||||

propagate that work, subject to this License. You are not responsible

|

||||

for enforcing compliance by third parties with this License.

|

||||

|

||||

An "entity transaction" is a transaction transferring control of an

|

||||

organization, or substantially all assets of one, or subdividing an

|

||||

organization, or merging organizations. If propagation of a covered

|

||||

work results from an entity transaction, each party to that

|

||||

transaction who receives a copy of the work also receives whatever

|

||||

licenses to the work the party's predecessor in interest had or could

|

||||

give under the previous paragraph, plus a right to possession of the

|

||||

Corresponding Source of the work from the predecessor in interest, if

|

||||

the predecessor has it or can get it with reasonable efforts.

|

||||

|

||||

You may not impose any further restrictions on the exercise of the

|

||||

rights granted or affirmed under this License. For example, you may

|

||||

not impose a license fee, royalty, or other charge for exercise of

|

||||

rights granted under this License, and you may not initiate litigation

|

||||

(including a cross-claim or counterclaim in a lawsuit) alleging that

|

||||

any patent claim is infringed by making, using, selling, offering for

|

||||

sale, or importing the Program or any portion of it.

|

||||

|

||||

11. Patents.

|

||||

|

||||

A "contributor" is a copyright holder who authorizes use under this

|

||||

License of the Program or a work on which the Program is based. The

|

||||

work thus licensed is called the contributor's "contributor version".

|

||||

|

||||

A contributor's "essential patent claims" are all patent claims

|

||||

owned or controlled by the contributor, whether already acquired or

|

||||

hereafter acquired, that would be infringed by some manner, permitted

|

||||

by this License, of making, using, or selling its contributor version,

|

||||

but do not include claims that would be infringed only as a

|

||||

consequence of further modification of the contributor version. For

|

||||

purposes of this definition, "control" includes the right to grant

|

||||

patent sublicenses in a manner consistent with the requirements of

|

||||

this License.

|

||||

|

||||

Each contributor grants you a non-exclusive, worldwide, royalty-free

|

||||

patent license under the contributor's essential patent claims, to

|

||||

make, use, sell, offer for sale, import and otherwise run, modify and

|

||||

propagate the contents of its contributor version.

|

||||

|

||||

In the following three paragraphs, a "patent license" is any express

|

||||

agreement or commitment, however denominated, not to enforce a patent

|

||||

(such as an express permission to practice a patent or covenant not to

|

||||

sue for patent infringement). To "grant" such a patent license to a

|

||||

party means to make such an agreement or commitment not to enforce a

|

||||

patent against the party.

|

||||

|

||||

If you convey a covered work, knowingly relying on a patent license,

|

||||

and the Corresponding Source of the work is not available for anyone

|

||||

to copy, free of charge and under the terms of this License, through a

|

||||

publicly available network server or other readily accessible means,

|

||||

then you must either (1) cause the Corresponding Source to be so

|

||||

available, or (2) arrange to deprive yourself of the benefit of the

|

||||

patent license for this particular work, or (3) arrange, in a manner

|

||||

consistent with the requirements of this License, to extend the patent

|

||||

license to downstream recipients. "Knowingly relying" means you have

|

||||

actual knowledge that, but for the patent license, your conveying the

|

||||

covered work in a country, or your recipient's use of the covered work

|

||||

in a country, would infringe one or more identifiable patents in that

|

||||

country that you have reason to believe are valid.

|

||||

|

||||

If, pursuant to or in connection with a single transaction or

|

||||

arrangement, you convey, or propagate by procuring conveyance of, a

|

||||

covered work, and grant a patent license to some of the parties

|

||||

receiving the covered work authorizing them to use, propagate, modify

|

||||

or convey a specific copy of the covered work, then the patent license

|

||||

you grant is automatically extended to all recipients of the covered

|

||||

work and works based on it.

|

||||

|

||||

A patent license is "discriminatory" if it does not include within

|

||||

the scope of its coverage, prohibits the exercise of, or is

|

||||

conditioned on the non-exercise of one or more of the rights that are

|

||||

specifically granted under this License. You may not convey a covered

|

||||

work if you are a party to an arrangement with a third party that is

|

||||

in the business of distributing software, under which you make payment

|

||||

to the third party based on the extent of your activity of conveying

|

||||

the work, and under which the third party grants, to any of the

|

||||

parties who would receive the covered work from you, a discriminatory

|

||||

patent license (a) in connection with copies of the covered work

|

||||

conveyed by you (or copies made from those copies), or (b) primarily

|

||||

for and in connection with specific products or compilations that

|

||||

contain the covered work, unless you entered into that arrangement,

|

||||

or that patent license was granted, prior to 28 March 2007.

|

||||

|

||||

Nothing in this License shall be construed as excluding or limiting

|

||||

any implied license or other defenses to infringement that may

|

||||

otherwise be available to you under applicable patent law.

|

||||

|

||||

12. No Surrender of Others' Freedom.

|

||||

|

||||

If conditions are imposed on you (whether by court order, agreement or

|

||||

otherwise) that contradict the conditions of this License, they do not

|

||||

excuse you from the conditions of this License. If you cannot convey a

|

||||

covered work so as to satisfy simultaneously your obligations under this

|

||||

License and any other pertinent obligations, then as a consequence you may

|

||||

not convey it at all. For example, if you agree to terms that obligate you

|

||||

to collect a royalty for further conveying from those to whom you convey

|

||||

the Program, the only way you could satisfy both those terms and this

|

||||

License would be to refrain entirely from conveying the Program.

|

||||

|

||||

13. Use with the GNU Affero General Public License.

|

||||

|

||||

Notwithstanding any other provision of this License, you have

|

||||

permission to link or combine any covered work with a work licensed

|

||||

under version 3 of the GNU Affero General Public License into a single

|

||||

combined work, and to convey the resulting work. The terms of this

|

||||

License will continue to apply to the part which is the covered work,

|

||||

but the special requirements of the GNU Affero General Public License,

|

||||

section 13, concerning interaction through a network will apply to the

|

||||

combination as such.

|

||||

|

||||

14. Revised Versions of this License.

|

||||

|

||||

The Free Software Foundation may publish revised and/or new versions of

|

||||

the GNU General Public License from time to time. Such new versions will

|

||||

be similar in spirit to the present version, but may differ in detail to

|

||||

address new problems or concerns.

|

||||

|

||||

Each version is given a distinguishing version number. If the

|

||||

Program specifies that a certain numbered version of the GNU General

|

||||

Public License "or any later version" applies to it, you have the

|

||||

option of following the terms and conditions either of that numbered

|

||||

version or of any later version published by the Free Software

|

||||

Foundation. If the Program does not specify a version number of the

|

||||

GNU General Public License, you may choose any version ever published

|

||||

by the Free Software Foundation.

|

||||

|

||||

If the Program specifies that a proxy can decide which future

|

||||

versions of the GNU General Public License can be used, that proxy's

|

||||

public statement of acceptance of a version permanently authorizes you

|

||||

to choose that version for the Program.

|

||||

|

||||

Later license versions may give you additional or different

|

||||

permissions. However, no additional obligations are imposed on any

|

||||

author or copyright holder as a result of your choosing to follow a

|

||||

later version.

|

||||

|

||||

15. Disclaimer of Warranty.

|

||||

|

||||

THERE IS NO WARRANTY FOR THE PROGRAM, TO THE EXTENT PERMITTED BY

|

||||

APPLICABLE LAW. EXCEPT WHEN OTHERWISE STATED IN WRITING THE COPYRIGHT

|

||||

HOLDERS AND/OR OTHER PARTIES PROVIDE THE PROGRAM "AS IS" WITHOUT WARRANTY

|

||||

OF ANY KIND, EITHER EXPRESSED OR IMPLIED, INCLUDING, BUT NOT LIMITED TO,

|

||||

THE IMPLIED WARRANTIES OF MERCHANTABILITY AND FITNESS FOR A PARTICULAR

|

||||

PURPOSE. THE ENTIRE RISK AS TO THE QUALITY AND PERFORMANCE OF THE PROGRAM

|

||||

IS WITH YOU. SHOULD THE PROGRAM PROVE DEFECTIVE, YOU ASSUME THE COST OF

|

||||

ALL NECESSARY SERVICING, REPAIR OR CORRECTION.

|

||||

|

||||

16. Limitation of Liability.

|

||||

|

||||

IN NO EVENT UNLESS REQUIRED BY APPLICABLE LAW OR AGREED TO IN WRITING

|

||||

WILL ANY COPYRIGHT HOLDER, OR ANY OTHER PARTY WHO MODIFIES AND/OR CONVEYS

|

||||

THE PROGRAM AS PERMITTED ABOVE, BE LIABLE TO YOU FOR DAMAGES, INCLUDING ANY

|

||||

GENERAL, SPECIAL, INCIDENTAL OR CONSEQUENTIAL DAMAGES ARISING OUT OF THE

|

||||

USE OR INABILITY TO USE THE PROGRAM (INCLUDING BUT NOT LIMITED TO LOSS OF

|

||||

DATA OR DATA BEING RENDERED INACCURATE OR LOSSES SUSTAINED BY YOU OR THIRD

|

||||

PARTIES OR A FAILURE OF THE PROGRAM TO OPERATE WITH ANY OTHER PROGRAMS),

|

||||

EVEN IF SUCH HOLDER OR OTHER PARTY HAS BEEN ADVISED OF THE POSSIBILITY OF

|

||||

SUCH DAMAGES.

|

||||

|

||||

17. Interpretation of Sections 15 and 16.

|

||||

|

||||

If the disclaimer of warranty and limitation of liability provided

|

||||

above cannot be given local legal effect according to their terms,

|

||||

reviewing courts shall apply local law that most closely approximates

|

||||

an absolute waiver of all civil liability in connection with the

|

||||

Program, unless a warranty or assumption of liability accompanies a

|

||||

copy of the Program in return for a fee.

|

||||

|

||||

END OF TERMS AND CONDITIONS

|

||||

|

||||

How to Apply These Terms to Your New Programs

|

||||

|

||||

If you develop a new program, and you want it to be of the greatest

|

||||

possible use to the public, the best way to achieve this is to make it

|

||||

free software which everyone can redistribute and change under these terms.

|

||||

|

||||

To do so, attach the following notices to the program. It is safest

|

||||

to attach them to the start of each source file to most effectively

|

||||

state the exclusion of warranty; and each file should have at least

|

||||

the "copyright" line and a pointer to where the full notice is found.

|

||||

|

||||

{one line to give the program's name and a brief idea of what it does.}

|

||||

Copyright (C) {year} {name of author}

|

||||

|

||||

This program is free software: you can redistribute it and/or modify

|

||||

it under the terms of the GNU General Public License as published by

|

||||

the Free Software Foundation, either version 3 of the License, or

|

||||

(at your option) any later version.

|

||||

|

||||

This program is distributed in the hope that it will be useful,

|

||||

but WITHOUT ANY WARRANTY; without even the implied warranty of

|

||||

MERCHANTABILITY or FITNESS FOR A PARTICULAR PURPOSE. See the

|

||||

GNU General Public License for more details.

|

||||

|

||||

You should have received a copy of the GNU General Public License

|

||||

along with this program. If not, see <http://www.gnu.org/licenses/>.

|

||||

|

||||

Also add information on how to contact you by electronic and paper mail.

|

||||

|

||||

If the program does terminal interaction, make it output a short

|

||||

notice like this when it starts in an interactive mode:

|

||||

|

||||

{project} Copyright (C) {year} {fullname}

|

||||

This program comes with ABSOLUTELY NO WARRANTY; for details type `show w'.

|

||||

This is free software, and you are welcome to redistribute it

|

||||

under certain conditions; type `show c' for details.

|

||||

|

||||

The hypothetical commands `show w' and `show c' should show the appropriate

|

||||

parts of the General Public License. Of course, your program's commands

|

||||

might be different; for a GUI interface, you would use an "about box".

|

||||

|

||||

You should also get your employer (if you work as a programmer) or school,

|

||||

if any, to sign a "copyright disclaimer" for the program, if necessary.

|

||||

For more information on this, and how to apply and follow the GNU GPL, see

|

||||

<http://www.gnu.org/licenses/>.

|

||||

|

||||

The GNU General Public License does not permit incorporating your program

|

||||

into proprietary programs. If your program is a subroutine library, you

|

||||

may consider it more useful to permit linking proprietary applications with

|

||||

the library. If this is what you want to do, use the GNU Lesser General

|

||||

Public License instead of this License. But first, please read

|

||||

<http://www.gnu.org/philosophy/why-not-lgpl.html>.

|

||||

|

|

@ -0,0 +1,626 @@

|

|||

<p align="center">

|

||||

<a href="https://www.apachecn.org">

|

||||

<img width="200" src="http://data.apachecn.org/img/logo.jpg">

|

||||

</a>

|

||||

<br >

|

||||

<a href="https://www.apachecn.org/"><img src="https://img.shields.io/badge/%3E-HOME-green.svg"></a>

|

||||

<a href="http://home.apachecn.org/about/"><img src="https://img.shields.io/badge/%3E-ABOUT-green.svg"></a>

|

||||

<a href="mailto:apache@163.com"><img src="https://img.shields.io/badge/%3E-Email-green.svg"></a>

|

||||

</p>

|

||||

|

||||

<h1 align="center"><a href="https://github.com/apachecn/AiLearning">AI learning</a></h1>

|

||||

|

||||

## 组织介绍

|

||||

|

||||

* 合作or侵权,请联系: `apachecn@163.com`

|

||||

* **我们不是 Apache 的官方组织/机构/团体,只是 Apache 技术栈(以及 AI)的爱好者!**

|

||||

* **ApacheCN - 学习机器学习群【629470233】<a target="_blank" href="//shang.qq.com/wpa/qunwpa?idkey=30e5f1123a79867570f665aa3a483ca404b1c3f77737bc01ec520ed5f078ddef"><img border="0" src="http://data.apachecn.org/img/logo/ApacheCN-group.png" alt="ApacheCN - 学习机器学习群[629470233]" title="ApacheCN - 学习机器学习群[629470233]"></a>**

|

||||

|

||||

> **欢迎任何人参与和完善:一个人可以走的很快,但是一群人却可以走的更远**

|

||||

|

||||

# 路线图

|

||||

|

||||

* 入门只看: 步骤 1 => 2 => 3,你可以当大牛!

|

||||

* 中级补充 - 资料库: <https://github.com/apachecn/ai-roadmap>

|

||||

|

||||

## 1.机器学习 - 基础

|

||||

|

||||

### 基本介绍

|

||||

|

||||

* 资料来源: Machine Learning in Action(机器学习实战-个人笔记)

|

||||

* 统一数据地址: <https://github.com/apachecn/data>

|

||||

* 书籍下载地址: <https://github.com/apachecn/data/tree/master/book>

|

||||

* 机器学习下载地址: <https://github.com/apachecn/data/tree/master/机器学习>

|

||||

* 深度学习数据地址: <https://github.com/apachecn/data/tree/master/深度学习>

|

||||

* 推荐系统数据地址: <https://github.com/apachecn/data/tree/master/推荐系统>

|

||||

* 视频网站:优酷 /bilibili / Acfun / 网易云课堂,可直接在线播放。(最下方有相应链接)

|

||||

* -- 推荐 [红色石头](https://github.com/RedstoneWill): [台湾大学林轩田机器学习笔记](https://github.com/apachecn/ntu-hsuantienlin-ml)

|

||||

* -- 推荐 [机器学习笔记](https://feisky.xyz/machine-learning): https://feisky.xyz/machine-learning

|

||||

|

||||

### 学习文档

|

||||

|

||||

<table>

|

||||

<tr>

|

||||

<th>模块</th>

|

||||

<th>章节</th>

|

||||

<th>类型</th>

|

||||

<th>负责人(GitHub)</th>

|

||||

<th>QQ</th>

|

||||

</tr>

|

||||

<tr>

|

||||

<td>机器学习实战</td>

|

||||

<td><a href="docs/ml/1.机器学习基础.md"> 第 1 章: 机器学习基础</a></td>

|

||||

<td>介绍</td>

|

||||

<td><a href="https://github.com/ElmaDavies">@毛红动</a></td>

|

||||

<td>1306014226</td>

|

||||

</tr>

|

||||

<tr>

|

||||

<td>机器学习实战</td>

|

||||

<td><a href="docs/ml/2.k-近邻算法.md">第 2 章: KNN 近邻算法</a></td>

|

||||

<td>分类</td>

|

||||

<td><a href="https://github.com/youyj521">@尤永江</a></td>

|

||||

<td>279393323</td>

|

||||

</tr>

|

||||

<tr>

|

||||

<td>机器学习实战</td>

|

||||

<td><a href="docs/ml/3.决策树.md">第 3 章: 决策树</a></td>

|

||||

<td>分类</td>

|

||||

<td><a href="https://github.com/jingwangfei">@景涛</a></td>

|

||||

<td>844300439</td>

|

||||

</tr>

|

||||

<tr>

|

||||

<td>机器学习实战</td>

|

||||

<td><a href="docs/ml/4.朴素贝叶斯.md">第 4 章: 朴素贝叶斯</a></td>

|

||||

<td>分类</td>

|

||||

<td><a href="https://github.com/wnma3mz">@wnma3mz</a><br/><a href="https://github.com/kailian">@分析</a></td>

|

||||

<td>1003324213<br/>244970749</td>

|

||||

</tr>

|

||||

<tr>

|

||||

<td>机器学习实战</td>

|

||||

<td><a href="docs/ml/5.Logistic回归.md">第 5 章: Logistic回归</a></td>

|

||||

<td>分类</td>

|

||||

<td><a href="https://github.com/DataMonk2017">@微光同尘</a></td>

|

||||

<td>529925688</td>

|

||||

</tr>

|

||||

<tr>

|

||||

<td>机器学习实战</td>

|

||||

<td><a href="docs/ml/6.支持向量机.md">第 6 章: SVM 支持向量机</a></td>

|

||||

<td>分类</td>

|

||||

<td><a href="https://github.com/VPrincekin">@王德红</a></td>

|

||||

<td>934969547</td>

|

||||

</tr>

|

||||

<tr>

|

||||

<td>网上组合内容</td>

|

||||

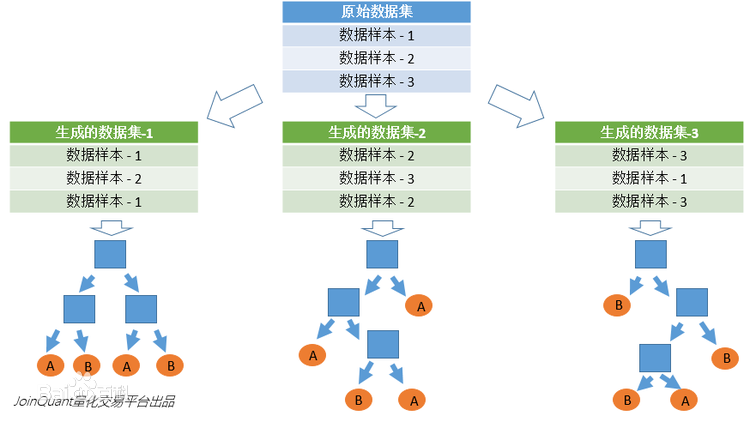

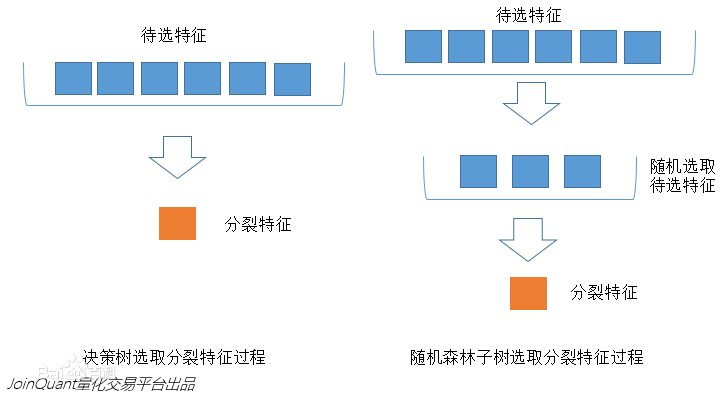

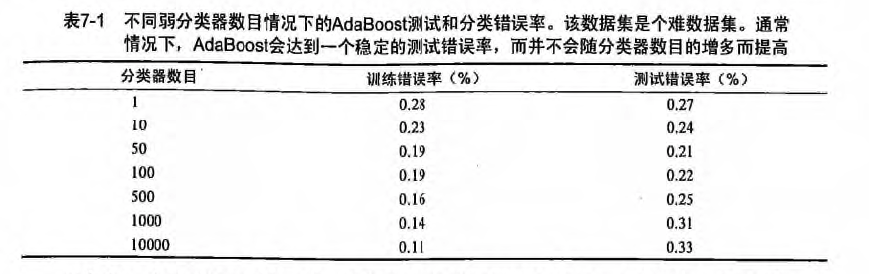

<td><a href="docs/ml/7.集成方法-随机森林和AdaBoost.md">第 7 章: 集成方法(随机森林和 AdaBoost)</a></td>

|

||||

<td>分类</td>

|

||||

<td><a href="https://github.com/jiangzhonglian">@片刻</a></td>

|

||||

<td>529815144</td>

|

||||

</tr>

|

||||

<tr>

|

||||

<td>机器学习实战</td>

|

||||

<td><a href="docs/ml/8.回归.md">第 8 章: 回归</a></td>

|

||||

<td>回归</td>

|

||||

<td><a href="https://github.com/DataMonk2017">@微光同尘</a></td>

|

||||

<td>529925688</td>

|

||||

</tr>

|

||||

<tr>

|

||||

<td>机器学习实战</td>

|

||||

<td><a href="docs/ml/9.树回归.md">第 9 章: 树回归</a></td>

|

||||

<td>回归</td>

|

||||

<td><a href="https://github.com/DataMonk2017">@微光同尘</a></td>

|

||||

<td>529925688</td>

|

||||

</tr>

|

||||

<tr>

|

||||

<td>机器学习实战</td>

|

||||

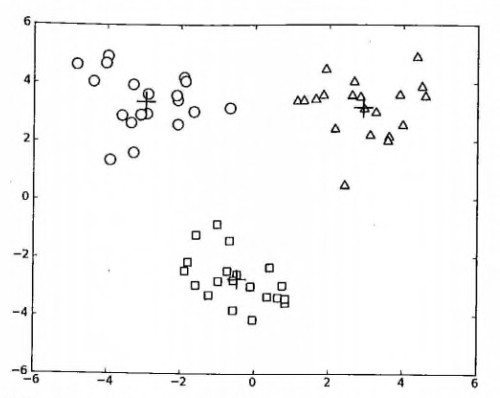

<td><a href="docs/ml/10.k-means聚类.md">第 10 章: K-Means 聚类</a></td>

|

||||

<td>聚类</td>

|

||||

<td><a href="https://github.com/xuzhaoqing">@徐昭清</a></td>

|

||||

<td>827106588</td>

|

||||

</tr>

|

||||

<tr>

|

||||

<td>机器学习实战</td>

|

||||

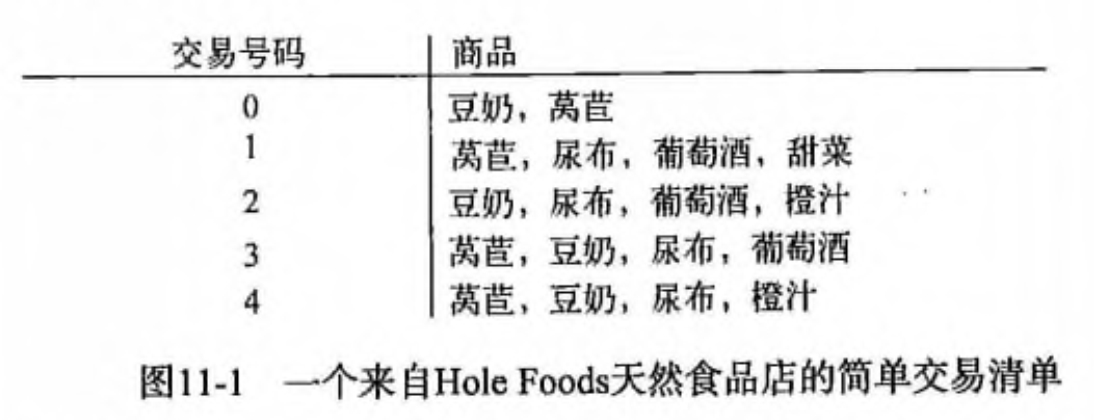

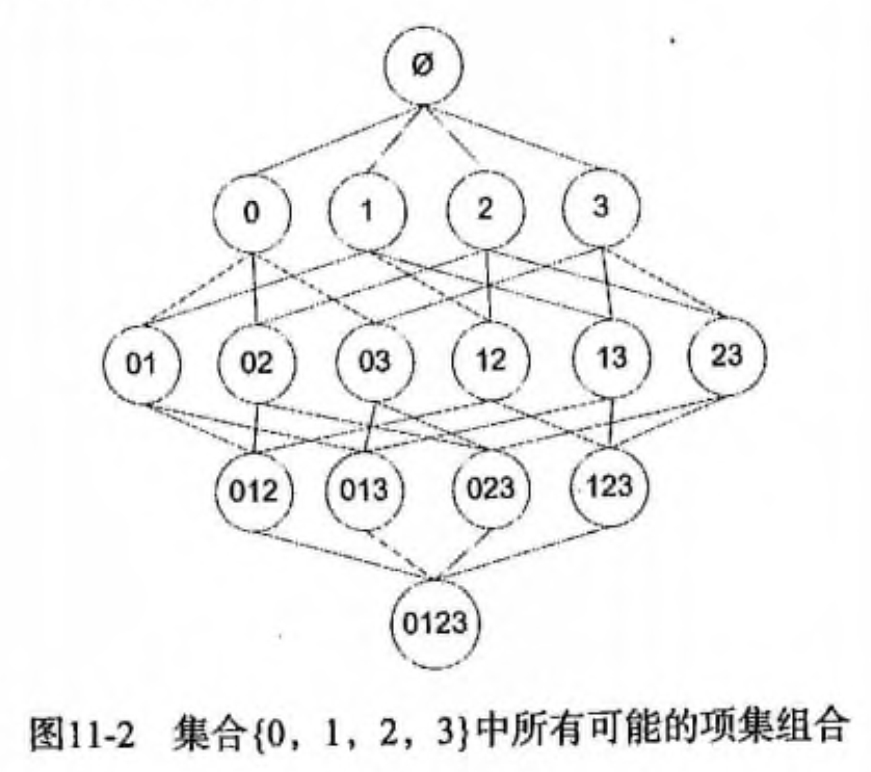

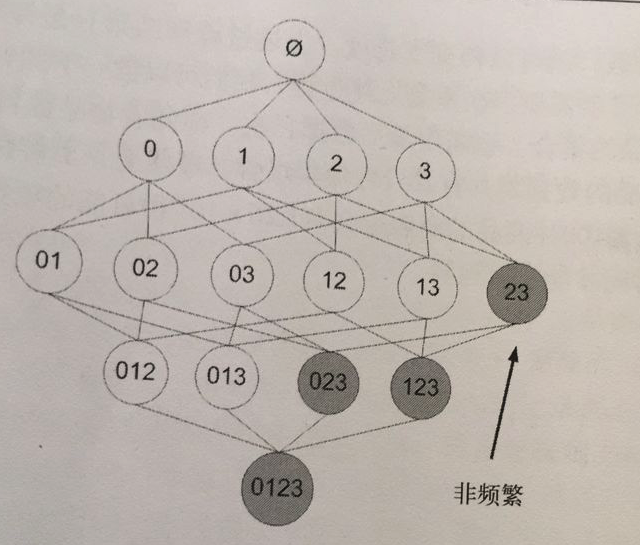

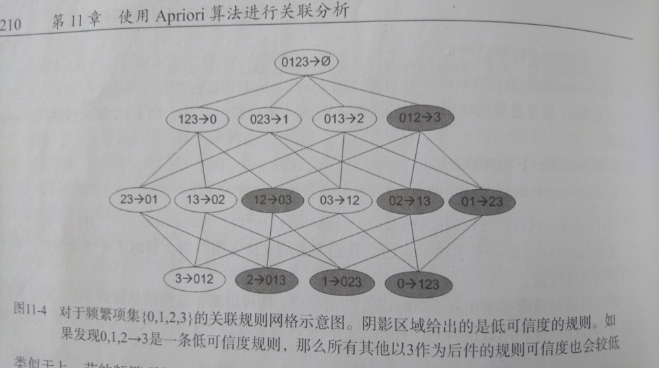

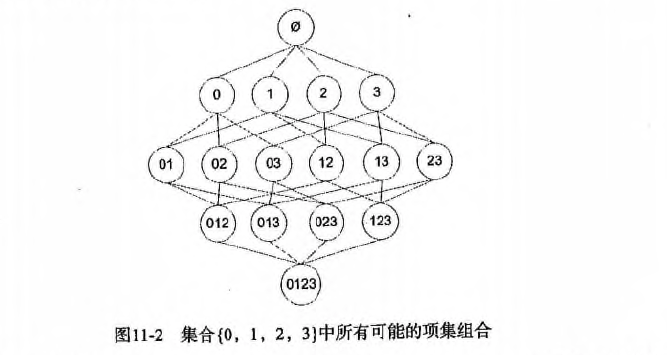

<td><a href="docs/ml/11.使用Apriori算法进行关联分析.md">第 11 章: 利用 Apriori 算法进行关联分析</a></td>

|

||||

<td>频繁项集</td>

|

||||

<td><a href="https://github.com/WindZQ">@刘海飞</a></td>

|

||||

<td>1049498972</td>

|

||||

</tr>

|

||||

<tr>

|

||||

<td>机器学习实战</td>

|

||||

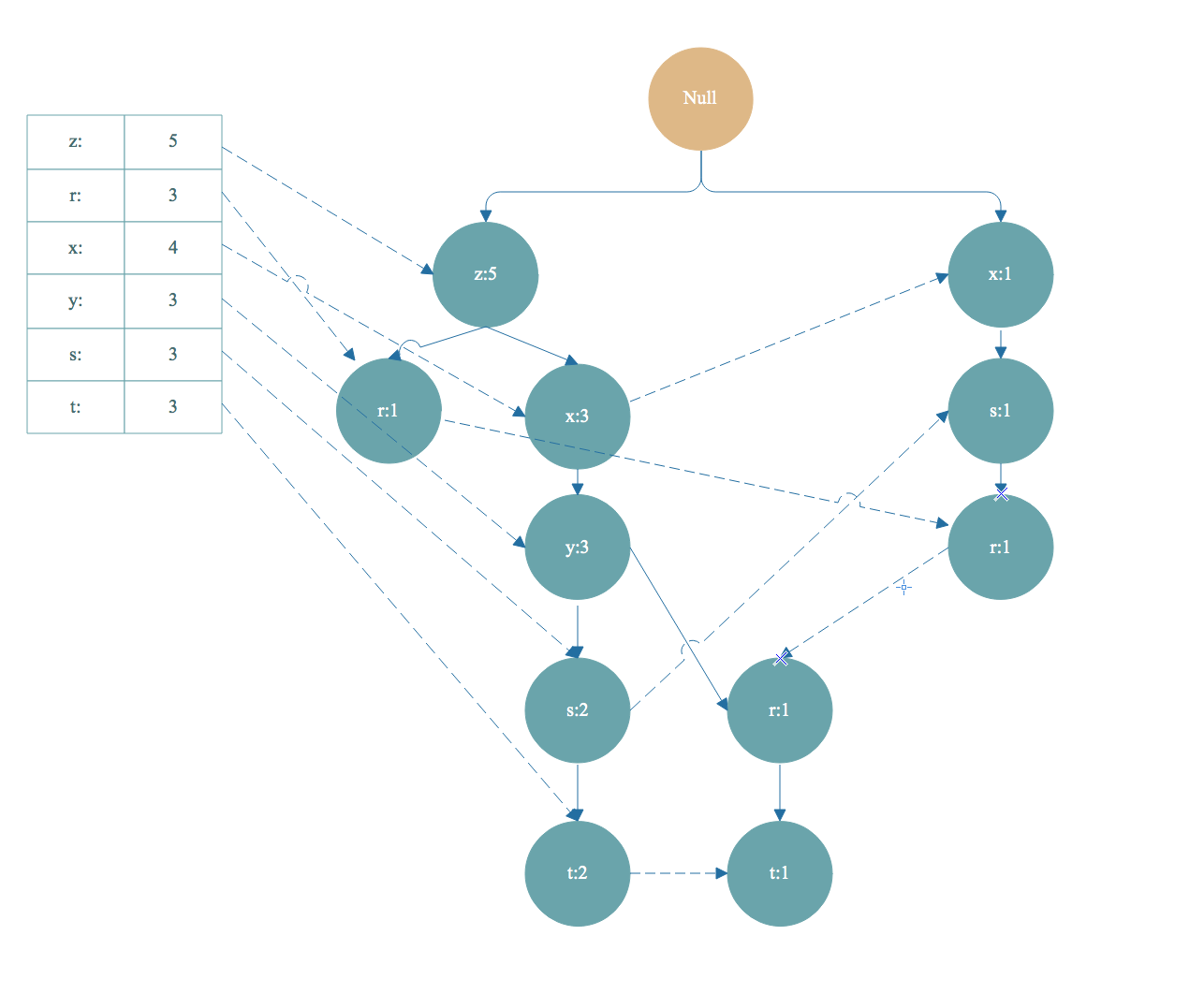

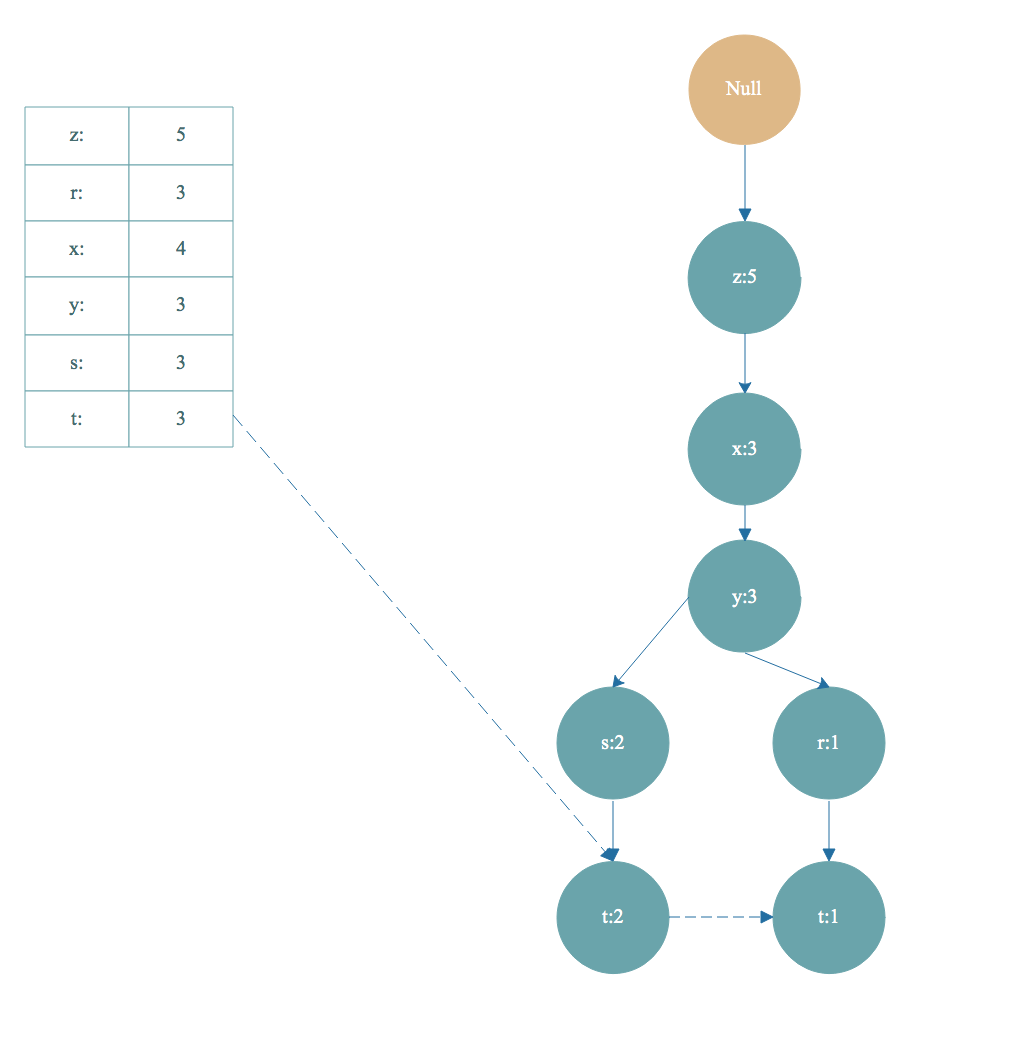

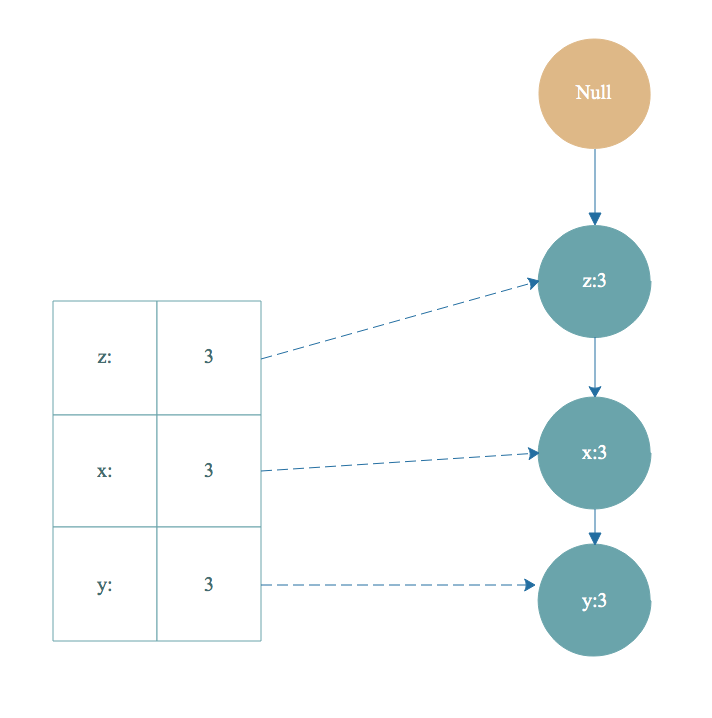

<td><a href="docs/ml/12.使用FP-growth算法来高效发现频繁项集.md">第 12 章: FP-growth 高效发现频繁项集</a></td>

|

||||

<td>频繁项集</td>

|

||||

<td><a href="https://github.com/mikechengwei">@程威</a></td>

|

||||

<td>842725815</td>

|

||||

</tr>

|

||||

<tr>

|

||||

<td>机器学习实战</td>

|

||||

<td><a href="docs/ml/13.利用PCA来简化数据.md">第 13 章: 利用 PCA 来简化数据</a></td>

|

||||

<td>工具</td>

|

||||

<td><a href="https://github.com/lljuan330">@廖立娟</a></td>

|

||||

<td>835670618</td>

|

||||

</tr>

|

||||

<tr>

|

||||

<td>机器学习实战</td>

|

||||

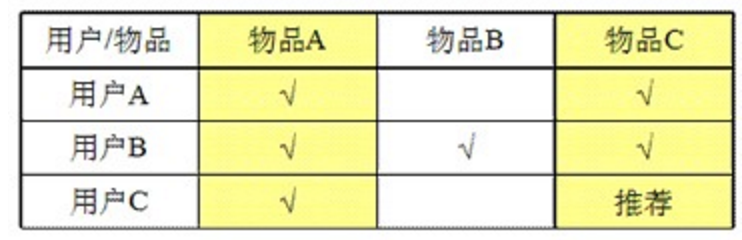

<td><a href="docs/ml/14.利用SVD简化数据.md">第 14 章: 利用 SVD 来简化数据</a></td>

|

||||

<td>工具</td>

|

||||

<td><a href="https://github.com/marsjhao">@张俊皓</a></td>

|

||||

<td>714974242</td>

|

||||

</tr>

|

||||

<tr>

|

||||

<td>机器学习实战</td>

|

||||

<td><a href="docs/ml/15.大数据与MapReduce.md">第 15 章: 大数据与 MapReduce</a></td>

|

||||

<td>工具</td>

|

||||

<td><a href="https://github.com/wnma3mz">@wnma3mz</a></td>

|

||||

<td>1003324213</td>

|

||||

</tr>

|

||||

<tr>

|

||||

<td>Ml项目实战</td>

|

||||

<td><a href="docs/ml/16.推荐系统.md">第 16 章: 推荐系统(已迁移)</a></td>

|

||||

<td>项目</td>

|

||||

<td><a href="https://github.com/apachecn/RecommenderSystems">推荐系统(迁移后地址)</a></td>

|

||||

<td></td>

|

||||

</tr>

|

||||

<tr>

|

||||

<td>第一期的总结</td>

|

||||

<td><a href="report/2017-04-08_第一期的总结.md">2017-04-08: 第一期的总结</a></td>

|

||||

<td>总结</td>

|

||||

<td>总结</td>

|

||||

<td>529815144</td>

|

||||

</tr>

|

||||

</table>

|

||||

|

||||

|

||||

### 网站视频

|

||||

|

||||

> [知乎问答-爆炸啦-机器学习该怎么入门?](https://www.zhihu.com/question/20691338/answer/248678328)

|

||||

|

||||

当然我知道,第一句就会被吐槽,因为科班出身的人,不屑的吐了一口唾沫,说傻X,还评论 Andrew Ng 的视频。。

|

||||

|

||||

我还知道还有一部分人,看 Andrew Ng 的视频就是看不懂,那神秘的数学推导,那迷之微笑的英文版的教学,我何尝又不是这样走过来的?? 我的心可能比你们都痛,因为我在网上收藏过上10部《机器学习》相关视频,外加国内本土风格的教程:7月+小象 等等,我都很难去听懂,直到有一天,被一个百度的高级算法分析师推荐说:《机器学习实战》还不错,通俗易懂,你去试试??

|

||||

|

||||

我试了试,还好我的Python基础和调试能力还不错,基本上代码都调试过一遍,很多高大上的 "理论+推导",在我眼中变成了几个 "加减乘除+循环",我想这不就是像我这样的程序员想要的入门教程么?

|

||||

|

||||

很多程序员说机器学习 TM 太难学了,是的,真 TM 难学,我想最难的是:没有一本像《机器学习实战》那样的作者愿意以程序员 Coding 角度去给大家讲解!!

|

||||

|

||||

最近几天,GitHub 涨了 300颗 star,加群的200人, 现在还在不断的增加++,我想大家可能都是感同身受吧!

|

||||

|

||||

很多想入门新手就是被忽悠着收藏收藏再收藏,但是最后还是什么都没有学到,也就是"资源收藏家",也许新手要的就是 [MachineLearning(机器学习) 学习路线图](http://www.apachecn.org/map/145.html)。没错,我可以给你们的一份,因为我们还通过视频记录下来我们的学习过程。水平当然也有限,不过对于新手入门,绝对没问题,如果你还不会,那算我输!!

|

||||

|

||||

> 视频怎么看?

|

||||

|

||||

|

||||

|

||||

1. 理论科班出身-建议去学习 Andrew Ng 的视频(Ng 的视频绝对是权威,这个毋庸置疑)

|

||||

2. 编码能力强 - 建议看我们的[《机器学习实战-教学版》](https://space.bilibili.com/97678687/#!/channel/detail?cid=22486)

|

||||

3. 编码能力弱 - 建议看我们的[《机器学习实战-讨论版》](https://space.bilibili.com/97678687/#!/channel/detail?cid=13045),不过在看理论的时候,看 教学版-理论部分;讨论版的废话太多,不过在讲解代码的时候是一行一行讲解的;所以,根据自己的需求,自由的组合。

|

||||

|

||||

> 【免费】数学教学视频 - 可汗学院 入门篇

|

||||

|

||||

* [@于振梓]() 推荐: 可汗学院-网易公开课

|

||||

|

||||

| 概率 | 统计 | 线性代数 |

|

||||

| - | - | - |

|

||||

| [可汗学院(概率)](http://open.163.com/special/Khan/probability.html) | [可汗学院(统计学)](http://open.163.com/special/Khan/khstatistics.html)| [可汗学院(线性代数)](http://open.163.com/special/Khan/linearalgebra.html)

|

||||

|

||||

> 机器学习视频 - ApacheCN 教学版

|

||||

|

||||

|||

|

||||

| - | - |

|

||||

| AcFun | B站 |

|

||||

| <a title="AcFun(机器学习视频)" href="http://www.acfun.cn/u/12540256.aspx#page=1" target="_blank"><img width="290" src="img/MainPage/ApacheCN-ML-AcFun.jpg"></a> | <a title="bilibili(机器学习视频)" href="https://space.bilibili.com/97678687/#!/channel/index" target="_blank"><img width="290" src="img/MainPage/ApacheCN-ML-bilibili.jpg"></a> |

|

||||

| 优酷 | 网易云课堂 |

|

||||

| <a title="YouKu(机器学习视频)" href="http://i.youku.com/apachecn" target="_blank"><img width="290" src="img/MainPage/ApacheCM-ML-youku.jpg"></a> | <a title="WangYiYunKeTang(机器学习视频)" href="http://study.163.com/course/courseMain.htm?courseId=1004582003" target="_blank"><img width="290" src="img/MainPage/ApacheCM-ML-WangYiYunKeTang.png"></a> |

|

||||

|

||||

> 【免费】机器/深度学习视频 - 吴恩达

|

||||

|

||||

| 机器学习 | 深度学习 |

|

||||

| - | - |

|

||||

| [吴恩达机器学习](http://study.163.com/course/courseMain.htm?courseId=1004570029) | [神经网络和深度学习](http://mooc.study.163.com/course/2001281002?tid=2001392029) |

|

||||

|

||||

|

||||

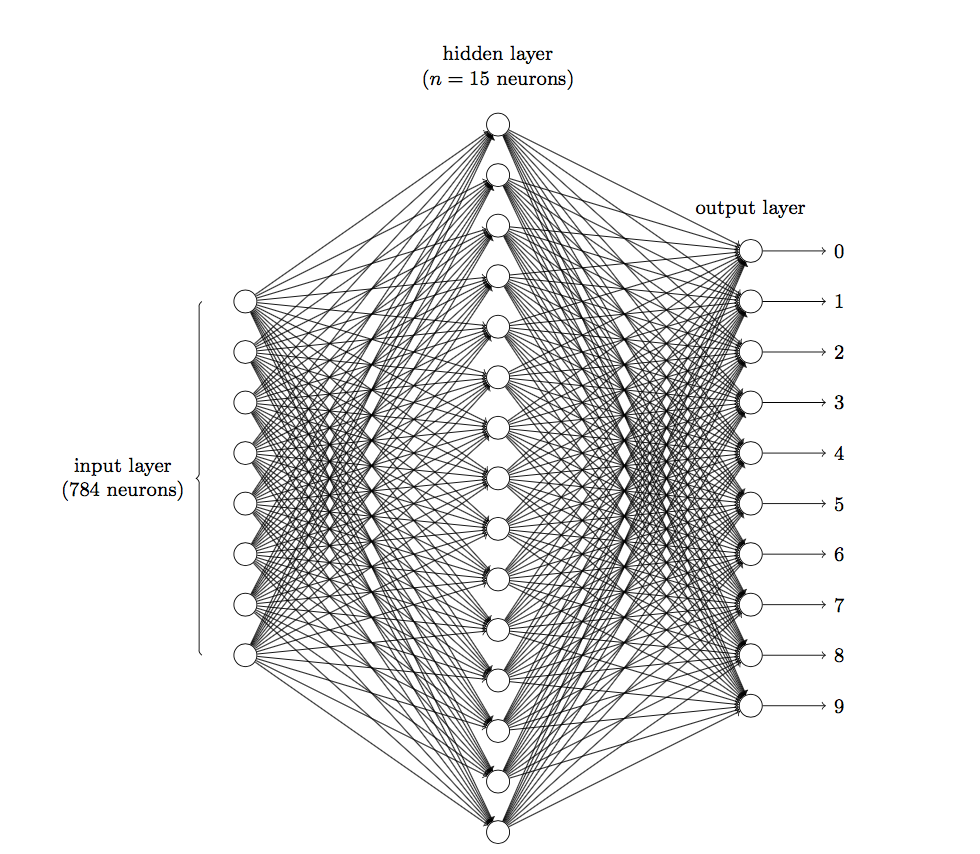

## 2.深度学习

|

||||

|

||||

### 入门基础

|

||||

|

||||

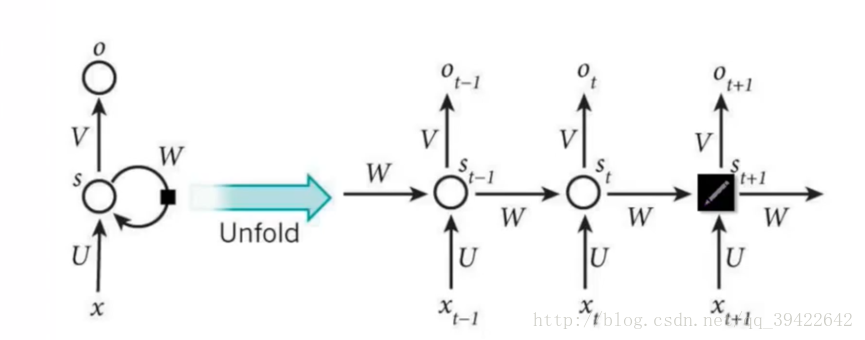

1. [反向传递](/docs/dl/反向传递.md): https://www.cnblogs.com/charlotte77/p/5629865.html

|

||||

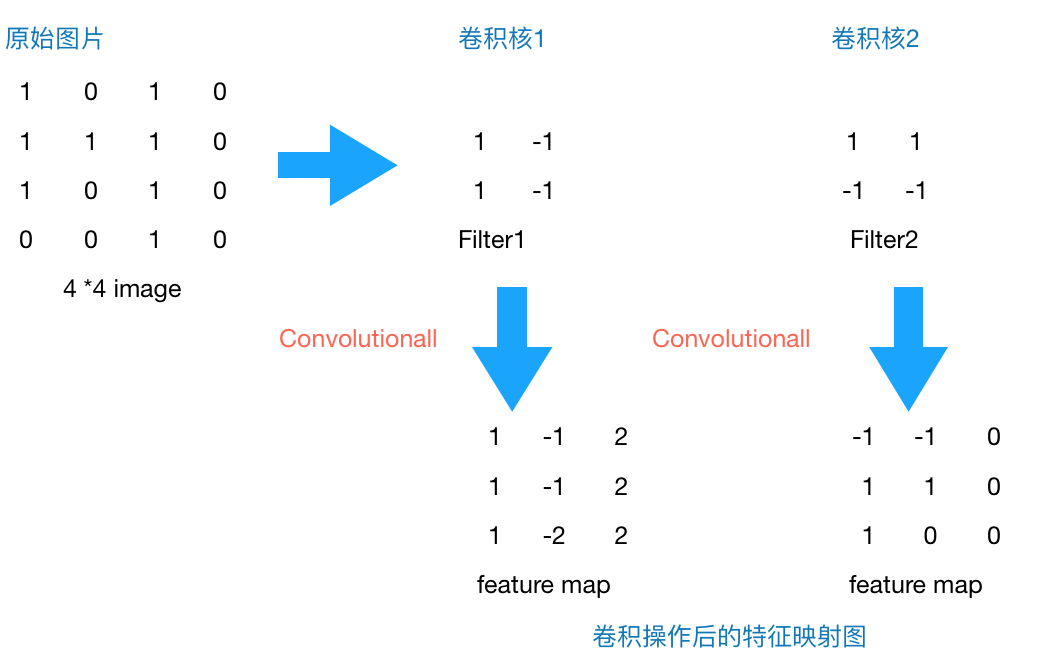

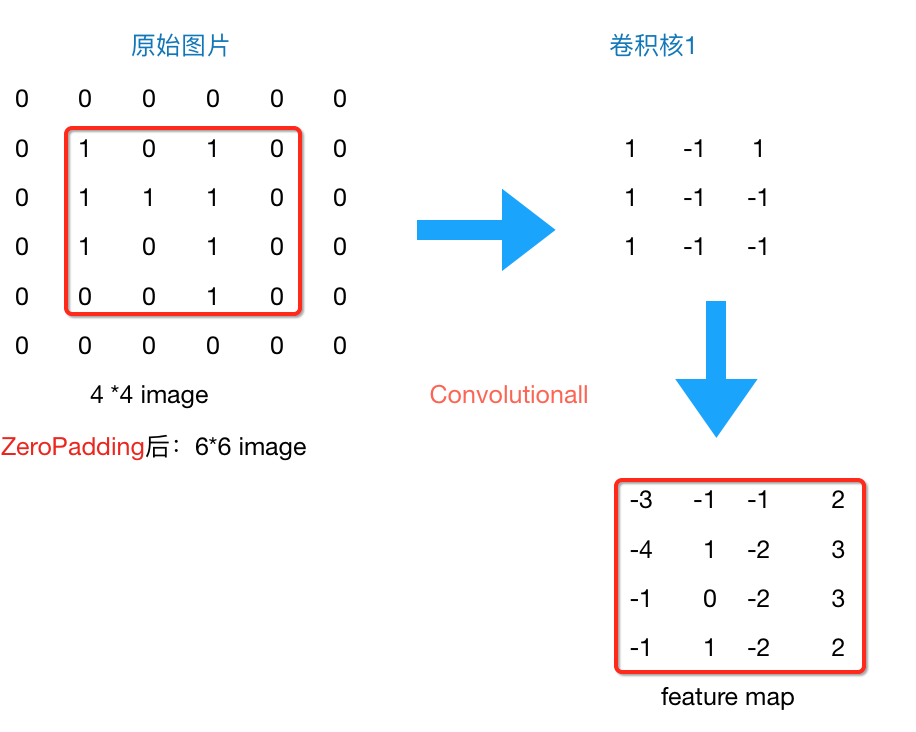

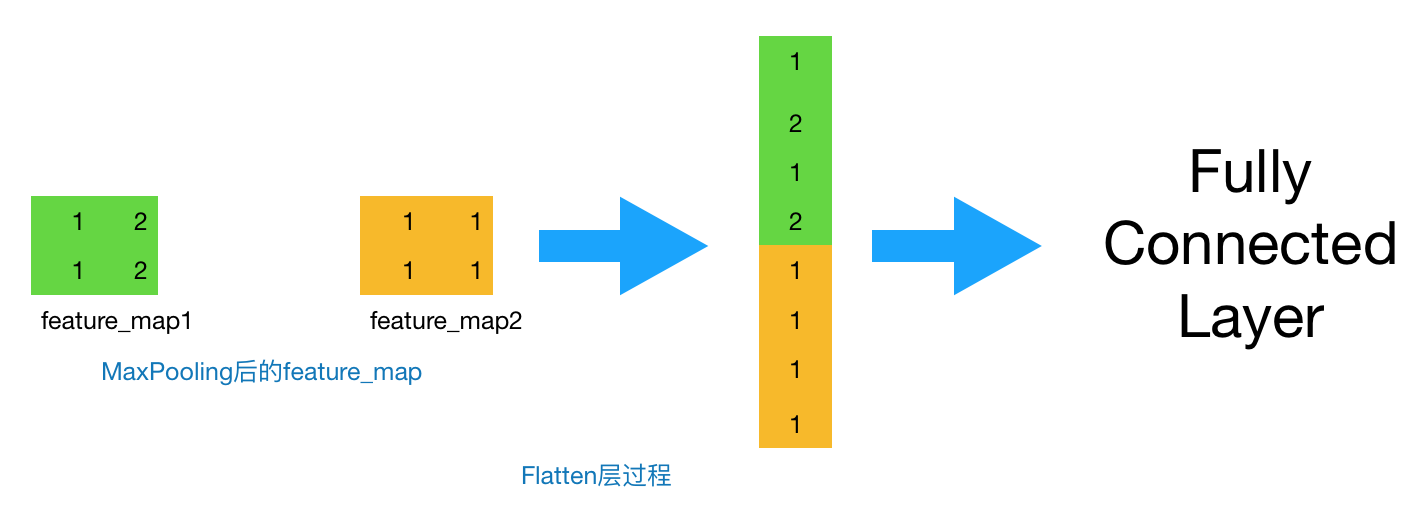

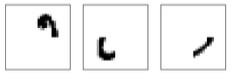

2. [CNN原理](/docs/dl/CNN原理.md): http://www.cnblogs.com/charlotte77/p/7759802.html

|

||||

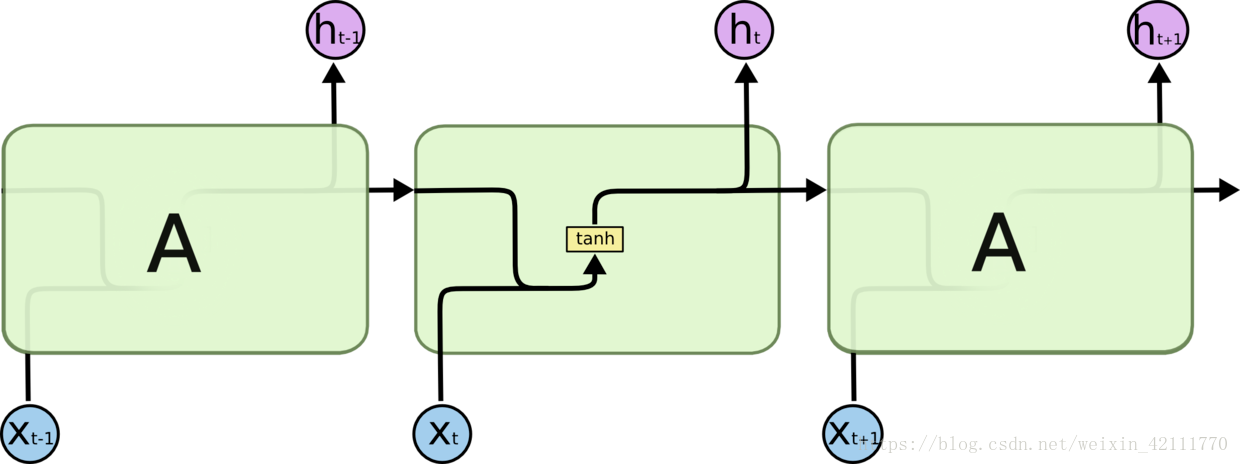

3. [RNN原理](/docs/dl/RNN原理.md): https://blog.csdn.net/qq_39422642/article/details/78676567

|

||||

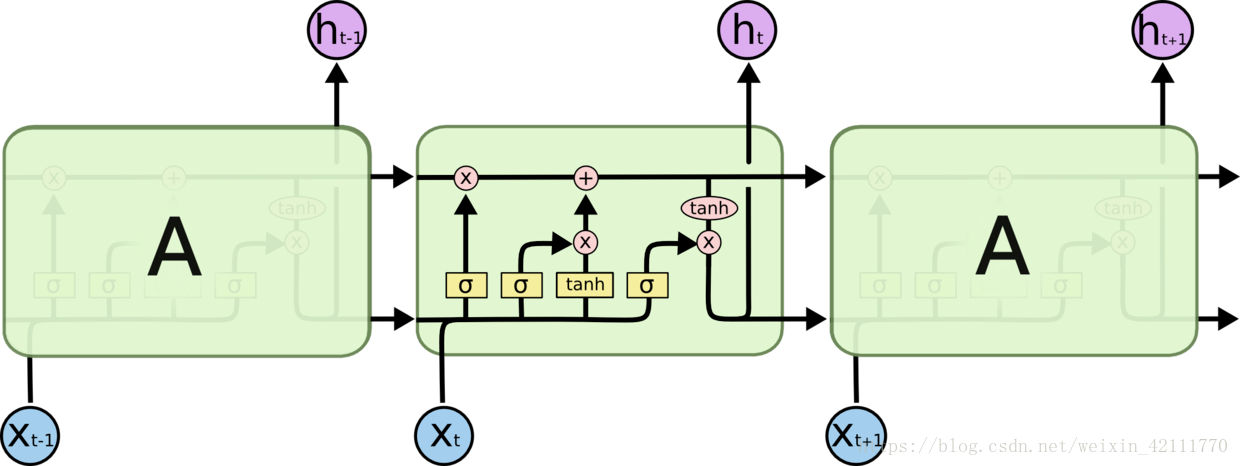

4. [LSTM原理](/docs/dl/LSTM原理.md): https://blog.csdn.net/weixin_42111770/article/details/80900575

|

||||

|

||||

### Pytorch - 教程

|

||||

|

||||

-- 待更新

|

||||

|

||||

### TensorFlow 2.0 - 教程

|

||||

|

||||

-- 待更新

|

||||

|

||||

> 目录结构:

|

||||

|

||||

* [安装指南](docs/TensorFlow2.x/安装指南.md)

|

||||

* [Kears 快速入门](docs/TensorFlow2.x/Keras快速入门.md)

|

||||

|

||||

## 3.自然语言处理

|

||||

|

||||

学习过程中-内心复杂的变化!!!

|

||||

|

||||

```python

|

||||

自从学习NLP以后,才发现国内与国外的典型区别:

|

||||

1. 对资源的态度是完全相反的:

|

||||

1) 国内:就好像为了名气,举办工作装逼的会议,就是没有干货,全部都是象征性的PPT介绍,不是针对在做的各位

|

||||

2)国外:就好像是为了推动nlp进步一样,分享者各种干货资料和具体的实现。(特别是: python自然语言处理)

|

||||

2. 论文的实现:

|

||||

1) 各种高大上的论文实现,却还是没看到一个像样的GitHub项目!(可能我的搜索能力差了点,一直没找到)

|

||||

2)国外就不举例了,我看不懂!

|

||||

3. 开源的框架

|

||||

1)国外的开源框架: tensorflow/pytorch 文档+教程+视频(官方提供)

|

||||

2) 国内的开源框架: 额额,还真举例不出来!但是牛逼吹得不比国外差!(MXNet虽然有众多国人参与开发,但不能算是国内开源框架。基于MXNet的动手学深度学习(http://zh.d2l.ai & https://discuss.gluon.ai/t/topic/753)中文教程,已经由沐神(李沐)以及阿斯顿·张讲授录制,公开发布(文档+第一季教程+视频)。)

|

||||

每一次深入都要去翻墙,每一次深入都要Google,每一次看着国内的说:哈工大、讯飞、中科大、百度、阿里多牛逼,但是资料还是得国外去找!

|

||||

有时候真的挺恨的!真的有点瞧不起自己国内的技术环境!

|

||||

|

||||

当然谢谢国内很多博客大佬,特别是一些入门的Demo和基本概念。【深入的水平有限,没看懂】

|

||||

```

|

||||

|

||||

|

||||

|

||||

* **【入门须知】必须了解**: <https://github.com/apachecn/AiLearning/tree/master/docs/nlp>

|

||||

* **【入门教程】强烈推荐: PyTorch 自然语言处理**: <https://github.com/apachecn/NLP-with-PyTorch>

|

||||

* Python 自然语言处理 第二版: <https://usyiyi.github.io/nlp-py-2e-zh>

|

||||

* 推荐一个[liuhuanyong大佬](https://github.com/liuhuanyong)整理的nlp全面知识体系: <https://liuhuanyong.github.io>

|

||||

* 开源 - 词向量库集合:

|

||||

* <https://github.com/Embedding/Chinese-Word-Vectors>

|

||||

* <https://github.com/brightmart/nlp_chinese_corpus>

|

||||

* <https://github.com/codemayq/chinese_chatbot_corpus>

|

||||

* <https://github.com/candlewill/Dialog_Corpus>

|

||||

|

||||

|

||||

### 1.使用场景 (百度公开课)

|

||||

|

||||

> 第一部分 入门介绍

|

||||

|

||||

* 1.) [自然语言处理入门介绍](/docs/nlp/1.自然语言处理入门介绍.md)

|

||||

|

||||

> 第二部分 机器翻译

|

||||

|

||||

* 2.) [机器翻译](/docs/nlp/2.机器翻译.md)

|

||||

|

||||

> 第三部分 篇章分析

|

||||

|

||||

* 3.1.) [篇章分析-内容概述](/docs/nlp/3.1.篇章分析-内容概述.md)

|

||||

* 3.2.) [篇章分析-内容标签](/docs/nlp/3.2.篇章分析-内容标签.md)

|

||||

* 3.3.) [篇章分析-情感分析](/docs/nlp/3.3.篇章分析-情感分析.md)

|

||||

* 3.4.) [篇章分析-自动摘要](/docs/nlp/3.4.篇章分析-自动摘要.md)

|

||||

|

||||

> 第四部分 UNIT-语言理解与交互技术

|

||||

|

||||

* 4.) [UNIT-语言理解与交互技术](/docs/nlp/4.UNIT-语言理解与交互技术.md)

|

||||

|

||||

### 应用领域

|

||||

|

||||

#### 中文分词:

|

||||

|

||||

* 构建DAG图

|

||||

* 动态规划查找,综合正反向(正向加权反向输出)求得DAG最大概率路径

|

||||

* 使用了SBME语料训练了一套 HMM + Viterbi 模型,解决未登录词问题

|

||||

|

||||

#### 1.文本分类(Text Classification)

|

||||

|

||||

文本分类是指标记句子或文档,例如电子邮件垃圾邮件分类和情感分析。

|

||||

|

||||

下面是一些很好的初学者文本分类数据集。

|

||||

|

||||

1. [路透社Newswire主题分类](http://kdd.ics.uci.edu/databases/reuters21578/reuters21578.html)(路透社-21578)。1987年路透社出现的一系列新闻文件,按类别编制索引。[另见RCV1,RCV2和TRC2](http://trec.nist.gov/data/reuters/reuters.html)。

|

||||

2. [IMDB电影评论情感分类(斯坦福)](http://ai.stanford.edu/~amaas/data/sentiment)。来自网站imdb.com的一系列电影评论及其积极或消极的情绪。

|

||||

3. [新闻组电影评论情感分类(康奈尔)](http://www.cs.cornell.edu/people/pabo/movie-review-data/)。来自网站imdb.com的一系列电影评论及其积极或消极的情绪。

|

||||

|

||||

有关更多信息,请参阅帖子:

|

||||

[单标签文本分类的数据集](http://ana.cachopo.org/datasets-for-single-label-text-categorization)。

|

||||

|

||||

> 情感分析

|

||||

|

||||

比赛地址: https://www.kaggle.com/c/word2vec-nlp-tutorial

|

||||

|

||||

* 方案一(0.86):WordCount + 朴素 Bayes

|

||||

* 方案二(0.94):LDA + 分类模型(knn/决策树/逻辑回归/svm/xgboost/随机森林)

|

||||

* a) 决策树效果不是很好,这种连续特征不太适合的

|

||||

* b) 通过参数调整 200 个topic,信息量保存效果较优(计算主题)

|

||||

* 方案三(0.72):word2vec + CNN

|

||||

* 说实话:没有一个好的机器,是调不出来一个好的结果 (: 逃

|

||||

|

||||

**通过AUC 来评估模型的效果**

|

||||

|

||||

#### 2.语言模型(Language Modeling)

|

||||

|

||||

语言建模涉及开发一种统计模型,用于预测句子中的下一个单词或一个单词中的下一个单词。它是语音识别和机器翻译等任务中的前置任务。

|

||||

|

||||

它是语音识别和机器翻译等任务中的前置任务。

|

||||

|

||||

下面是一些很好的初学者语言建模数据集。

|

||||

|

||||

1. [古腾堡项目](https://www.gutenberg.org/),一系列免费书籍,可以用纯文本检索各种语言。

|

||||

2. 还有更多正式的语料库得到了很好的研究; 例如:

|

||||

[布朗大学现代美国英语标准语料库](https://en.wikipedia.org/wiki/Brown_Corpus)。大量英语单词样本。

|

||||

[谷歌10亿字语料库](https://github.com/ciprian-chelba/1-billion-word-language-modeling-benchmark)。

|

||||

|

||||

> 新词发现

|

||||

|

||||

* 中文分词新词发现

|

||||

* python3利用互信息和左右信息熵的中文分词新词发现

|

||||

* <https://github.com/zhanzecheng/Chinese_segment_augment>

|

||||

|

||||

> 句子相似度识别

|

||||

|

||||

* 项目地址: https://www.kaggle.com/c/quora-question-pairs

|

||||

* 解决方案: word2vec + Bi-GRU

|

||||

|

||||

> 文本纠错

|

||||

|

||||

* bi-gram + levenshtein

|

||||

|

||||

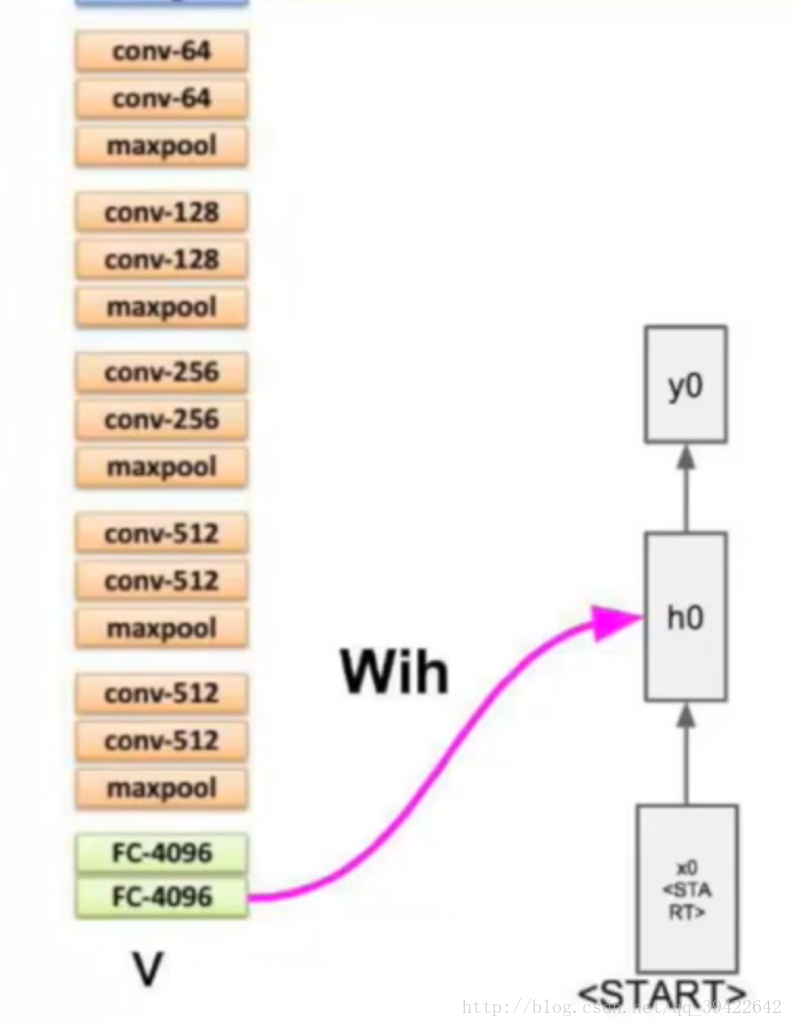

#### 3.图像字幕(Image Captioning)

|

||||

|

||||

mage字幕是为给定图像生成文本描述的任务。

|

||||

|

||||

下面是一些很好的初学者图像字幕数据集。

|

||||

|

||||

1. [上下文中的公共对象(COCO)](http://mscoco.org/dataset/#overview)。包含超过12万张带描述的图像的集合

|

||||

2. [Flickr 8K](http://nlp.cs.illinois.edu/HockenmaierGroup/8k-pictures.html)。从flickr.com获取的8千个描述图像的集合。

|

||||

3. [Flickr 30K](http://shannon.cs.illinois.edu/DenotationGraph/)。从flickr.com获取的3万个描述图像的集合。

|

||||

欲了解更多,请看帖子:

|

||||

|

||||

[探索图像字幕数据集,2016年](http://sidgan.me/technical/2016/01/09/Exploring-Datasets)

|

||||

|

||||

#### 4.机器翻译(Machine Translation)

|

||||

|

||||

机器翻译是将文本从一种语言翻译成另一种语言的任务。

|

||||

|

||||

下面是一些很好的初学者机器翻译数据集。

|

||||

|

||||

1. [加拿大第36届议会的协调国会议员](https://www.isi.edu/natural-language/download/hansard/)。成对的英语和法语句子。

|

||||

2. [欧洲议会诉讼平行语料库1996-2011](http://www.statmt.org/europarl/)。句子对一套欧洲语言。

|

||||

有大量标准数据集用于年度机器翻译挑战; 看到:

|

||||

|

||||

[统计机器翻译](http://www.statmt.org/)

|

||||

|

||||

> 机器翻译

|

||||

|

||||

* Encoder + Decoder(Attention)

|

||||

* 参考案例: http://pytorch.apachecn.org/cn/tutorials/intermediate/seq2seq_translation_tutorial.html

|

||||

|

||||

#### 5.问答系统(Question Answering)

|

||||

|

||||

问答是一项任务,其中提供了一个句子或文本样本,从中提出问题并且必须回答问题。

|

||||

|

||||

下面是一些很好的初学者问题回答数据集。

|

||||

|

||||

1. [斯坦福问题回答数据集(SQuAD)](https://rajpurkar.github.io/SQuAD-explorer/)。回答有关维基百科文章的问题。

|

||||

2. [Deepmind问题回答语料库](https://github.com/deepmind/rc-data)。从每日邮报回答有关新闻文章的问题。

|

||||

3. [亚马逊问答数据](http://jmcauley.ucsd.edu/data/amazon/qa/)。回答有关亚马逊产品的问题。

|

||||

有关更多信息,请参阅帖子:

|

||||

|

||||

[数据集:我如何获得问答网站的语料库,如Quora或Yahoo Answers或Stack Overflow来分析答案质量?](https://www.quora.com/Datasets-How-can-I-get-corpus-of-a-question-answering-website-like-Quora-or-Yahoo-Answers-or-Stack-Overflow-for-analyzing-answer-quality)

|

||||

|

||||

#### 6.语音识别(Speech Recognition)

|

||||

|

||||

语音识别是将口语的音频转换为人类可读文本的任务。

|

||||

|

||||

下面是一些很好的初学者语音识别数据集。

|

||||

|

||||

1. [TIMIT声学 - 语音连续语音语料库](https://catalog.ldc.upenn.edu/LDC93S1)。不是免费的,但因其广泛使用而上市。口语美国英语和相关的转录。

|

||||

2. [VoxForge](http://voxforge.org/)。用于构建用于语音识别的开源数据库的项目。

|

||||

3. [LibriSpeech ASR语料库](http://www.openslr.org/12/)。从LibriVox收集的大量英语有声读物。

|

||||

|

||||

#### 7.自动文摘(Document Summarization)

|

||||

|

||||

文档摘要是创建较大文档的简短有意义描述的任务。

|

||||

|

||||

下面是一些很好的初学者文档摘要数据集。

|

||||

|

||||

1. [法律案例报告数据集](https://archive.ics.uci.edu/ml/datasets/Legal+Case+Reports)。收集了4000份法律案件及其摘要。

|

||||

2. [TIPSTER文本摘要评估会议语料库](http://www-nlpir.nist.gov/related_projects/tipster_summac/cmp_lg.html)。收集了近200份文件及其摘要。

|

||||

3. [英语新闻文本的AQUAINT语料库](https://catalog.ldc.upenn.edu/LDC2002T31)。不是免费的,而是广泛使用的。新闻文章的语料库。

|

||||

欲了解更多信息:

|

||||

|

||||

[文档理解会议(DUC)任务](http://www-nlpir.nist.gov/projects/duc/data.html)。

|

||||

[在哪里可以找到用于文本摘要的良好数据集?](https://www.quora.com/Where-can-I-find-good-data-sets-for-text-summarization)

|

||||

|

||||

> 命名实体识别

|

||||

|

||||

* Bi-LSTM CRF

|

||||